Presentacin de PowerPoint PowerPoint PPT Presentation

1 / 17

Title: Presentacin de PowerPoint

1

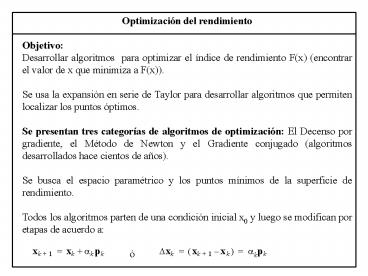

Optimización del rendimiento Objetivo Desarrolla

r algoritmos para optimizar el índice de

rendimiento F(x) (encontrar el valor de x que

minimiza a F(x)). Se usa la expansión en serie

de Taylor para desarrollar algoritmos que

permiten localizar los puntos óptimos. Se

presentan tres categorías de algoritmos de

optimización El Decenso por gradiente, el Método

de Newton y el Gradiente conjugado (algoritmos

desarrollados hace cientos de años). Se busca el

espacio paramétrico y los puntos mínimos de la

superficie de rendimiento. Todos los algoritmos

parten de una condición inicial x0 y luego se

modifican por etapas de acuerdo a

ó

2

Pk representa una dirección de búsqueda y el

escalar positivo ?k es la tasa de aprendizaje, la

cual determina la longitud del paso.

Decenso por Gradiente Cuando se busca el nuevo

x (punto óptimo mínimo) con la ecuación mostrada,

sería deseable que la función decreciera en cada

iteración F(xk1) lt F(xk) Cómo escoger una

dirección Pk, tal que para una tasa de

aprendizaje suficientemente pequeña, nos podamos

mover colina abajo en la función?. La

expansión en serie de Taylor de primer orden de

F(x) respecto a la vieja xk

3

con

Para que se cumpla que F(xk1) lt F(xk), el

segundo término del lado derecho de F(xk1) debe

ser negativo

Trabajando con un ?k pequeño pero positivo gTkpk

lt 0 Dirección Decendiente Cualquier vector Pk

que satisface esa ecuación se llama Dirección

Decendiente. La función decrecerá si se toma un

paso suficientemente pequeño en esa dirección.

Ahora, cuál es la dirección del Decenso por

gradiente? (en qué dirección la función

descenderá más rápidamente?). Esto sucede cuando

gTkpk es más negativa (suponiendo que la longitud

de pk no cambia, solo la dirección).

4

Tenemos un producto interno entre el gradiente y

un vector de dirección. Será más negativo cuando

el vector de dirección sea el negativo del

gradiente. Por lo tanto un vector que apunta en

la dirección del decenso por gradiente es

Luego, el método del Decenso por Gradiente es

Métodos para determinar la tasa de aprendizaje

del Decenso por Gradiente Un enfoque es

minimizar el índice de rendimiento F(x) con

respecto a ?k en cada iteración. En este caso se

minimiza a lo largo de la línea xk - ?kgk. El

otro método para seleccionar ?k consiste en usar

un valor fijo (ejemplo, ?k 0.02) o usar una

variable con valores predeterminados, ejemplo, ?k

1/k.

5

Ejemplo Aplicar el algoritmo Decenso por

gradiente a la siguiente función

6

Si se incrementa la tasa de aprendizaje, la

trayectoria seguida a través de las x puede

oscilar, y si se selecciona demasiado grande la

trayectoria puede llegar a un comportamiento

inestable, de tal manera que las oscilaciones se

incrementarían en lugar de decrecer. No es

posible predecir el máximo valor para la tasa de

aprendizaje en funciones arbitrarias pero para

funciones cuadráticas se puede establecer un

límite superior. Tasas de aprendizaje estables

Para índices de rendimiento cuadráticos

El gradiente de la función cuadrática es Si se

supone una tasa de aprendizaje constante, el

algoritmo del decenso por gradiente será

ó

7

Este es un sistema dinámico lineal, el cual será

estable si los autovalores de I-?A son menores

que 1 en magnitud. Se pueden expresar los

autovalores de esta matriz en términos de los

autovalores del Hessiano A Sean los ?i los

autovalores y los zi los autovalores del Hessiano

A

los autovectores de I-?A son los mismos que los

de A, y los autovalores de I-?A son (1- ??i).

La condición de estabilidad para el algoritmo del

decenso por gradiente es que

Si se supone que la ecuación cuadrática tienen un

mínimo local, sus autovalores deben ser positivos

8

Como esto es cierto para todos los autovalores

del Hessiano, entonces

La tasa de aprendizaje estable máxima es

inversamente proporcional a la máxima curvatura

de la función cuadrática. La curvatura muestra la

rapidez con la cual cambia el gradiente. El

algoritmo converge más lentamente en la dirección

del autovector que corresponde al autovalor más

pequeño (en el otro caso nos podemos saltar el

punto mínimo al dar saltos muy grandes). Cuando

hay grandes diferencias en magnitud entre el

autovalor más pequeño y el más grande, el

algoritmo converge lentamente.

Minimizando a lo largo de una línea

El otro enfoque para seleccionar la tasa de

aprendizaje es minimizar el índice de rendimiento

con respecto a ?k en cada iteración. Es decir, se

escoge ?k para minimizar

9

Para funciones cuadráticas es posible la

minimización lineal analíticamente

(para funciones cuadráticas el Hessiano no es una

función de k). El Método de Newton El método de

Newton está basado en la serie de Taylor de

segundo orden.

La idea es localizar el punto estacionario de

esta aproximación cuadrática para F(x). Si se

toma el gradiente de esta función cuadrática

respecto a ?xk y la igualamos a cero

10

El algoritmo de Newton se define por

Este método encuentra el mínimo de la función

cuadrática en un paso. Si la función F(x) no es

cuadrática no converge en un paso (no encuentra

el mínimo en un paso), de hecho no hay seguridad

que ocurra convergencia, dado que depende de la

función y de las condiciones iniciales. El

método de Newton converge rápidamente en muchas

aplicaciones puesto que las funciones analíticas

se pueden aproximar por funciones cuadráticas en

pequeñas vecindades de un mínimo local. El

decenso por gradiente garantiza convergencia

cuando la tasa de aprendizaje no es muy grande o

si se realiza una minimización lineal en cada

etapa, mientras que el método de Newton no,

oscila, diverge. Cuando converge el método de

Newton es más rápido. El método de Newton puede

converger a puntos de ensilladura.

11

El Gradiente conjugado El método de Newton tiene

una propiedad llamada terminación cuadrática, que

significa que minimiza una función cuadrática en

un número finito de iteraciones, para ello

necesita calcular y almacenar la segunda

derivada. Cuando el número de parámetros n, es

grande es poco práctico calcular todas las

segundas derivadas. En las aplicaciones de las

ANN se pueden utilizar miles de pesos. Para esos

casos, desearíamos utilizar métodos que requieran

las primeras derivadas y contar también con la

terminación cuadrática. Del decenso por

gradiente con búsqueda lineal, en cada iteración

las direcciones de búsqueda en iteraciones

consecutivas son ortogonales. Supongamos que

buscamos el mínimo de la siguiente función

cuadrática

Un conjunto de vectores pk es mutuamente

conjugado con respecto a un Hessiano A definido

positivo si y solo si

12

Hay un número infinito de conjuntos de vectores

mutuamente conjugados que expanden a un espacio n

dimensional dado. Un conjunto de esos vectores es

el de los autovectores de A.

La igualdad se mantiene debido a que los

autovalores de una matriz simétrica son

mutuamente ortogonales. Por lo tanto, los

autovectores son conjugados y ortogonales. Este

procedimiento no es deseable en la práctica

debido a que hay que buscar la matriz Hessiano,

es decir, la segunda derivada. Cómo usar la

expresión anterior sin usar el Hessiano?.

Recordemos que para funciones cuadráticas

Combinado esas ecuaciones el cambio en el

gradiente en la iteración k1 es

13

Con

ak se escoge para minimizar F(x) en la dirección

de pk. Re-escribiendo la ecuación con las

condiciones conjugadas

?

Podemos ver que no necesitamos el Hessiano, sino

los cambios en el gradiente en las sucesivas

iteraciones del algoritmo.

El primer vector puede ser arbitrario p0, y p1

puede ser cualquier vector ortogonal a ?g0. Es

común comenzar el algoritmo con la dirección en

el decenso por gradiente (gradiente negativo)

En cada iteración se requiere construir un pk

ortogonal a ?g1, ?g2, ... , ?gk-1. Este es un

procedimiento similar a la ortogonalización

Gram-schmidt. El algoritmo es

14

Los escalares ßk se escogen comúnmente de tres

maneras

ak se escoge de acuerdo al método de minimización

a lo largo de una línea

Si el algoritmo no converge se repite el

proceso. Se encontrará el mínimo de una función

cuadrática en n pasos. Es decir, el algoritmo

converge exactamente en un número de pasos igual

a la dimensión de la matriz de la función

cuadrática.

15

Ejemplo

16

(No Transcript)

17

(No Transcript)